Data Mining: Analysemethoden für Mustererkennung

Letztes Update 27.10.2014, finale Version wird erwartet am 29.10.2014

Inhaltsverzeichnis

- 1 Was ist Data Mining?

- 2 Techniken / Analysemethoden

- 3 Woher kommen die Daten?

- 4 Wie kann man so viele Daten auswerten?

- 5 Resultate

- 6 Privatsphäre

- 7 Wozu?

- 8 Quellenverzeichnis

Was ist Data Mining?

Data Mining ist auch bekannt unter dem Begriff KDD (Knowledge Discovery in Database), was die Identifikation gültiger, neuartiger, potenziell nützlicher und verständlicher Muster in Daten, wie auch Statistik, Optimierung und künstliche Intelligenz Elemente beinhaltet. Folgend ein paar umschreibende Merkmale, was Data Mining ist:

• Nicht nur die Zusammenfassung von Daten, sondern umAbhängigkeiten und Beziehungen zwischen Daten feststellen

• Interpretation der Muster: herausheben von „verstecktem“ Wissen (entdeckungsgetriebenes System)

• Durch Verallgemeinerung und Übertragung auf andere Datensammlung kann neues Wissen erzeugt werden. (verifikationsgetriebenes System)

• Automatisierte…:

o Vorhersage von Trends, Verhalten und Mustern auf der Basis von bekannten Verhaltensschemata aus der Vergangenheit.

o Aufdeckung unbekannter Strukturen aus bisher ungeordneten Datenzweigen

• Mit zusätzlichen Tools eine Datenaufbereitung und -transformation durchführen sowie die Ergebnisaufbereitung (Visualisierung)

• Eine kurze Definition für Laien: Data Mining ist das Erkennbar machen von für das menschliche Auge nicht sichtbare Informationen und Zusammenhängen in grossen Datenmengen durch Verwendung von verschiedenen Analysemethoden.

Techniken / Analysemethoden

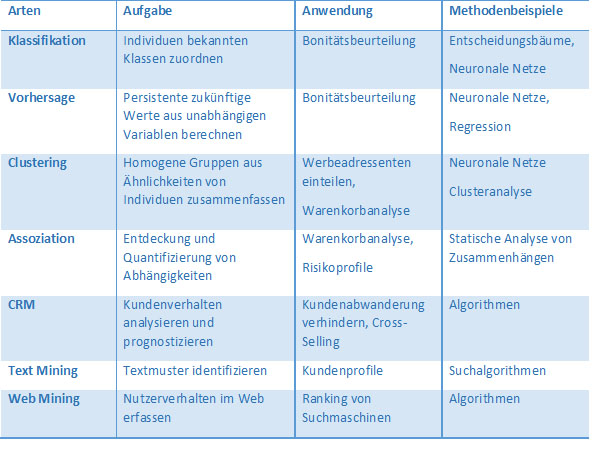

Bei Banken, Kreditunternehmen und Versicherungen wird Data Mining beispielsweise angewendet um neue potenzielle Kunden zu finden und gleichzeitig die Kundenabwanderung zu verhindern. In der Medizin kann die Dateninterpretation in automatisierter Diagnostik angewendet werden. Tabelle 1: Analysemethoden. Angelehnt an: „Entwickler Magazin 3.2013:Verborgene Schätze heben, S.64“

Klassifikation

Die Klassifizierung dient dazu, die Zugehörigkeit von Daten vorherzusagen. Ziel ist es, Objekte auf Grund von individuellen Merkmalskombinationen in mindestens zwei vorggegebene Klassen einzutragen. Während des Klassifikationsprozesses werden die Klasseneigenschaften mit Objektmerkmalen verglichen.

Vorhersage

Bei der Vorhersage wird versucht mit einer Regressionsanalyse Aussagen zu evaluieren. So werden zukünftige Werte errechnet um beispielsweise des Verkaufstrends für das nächste Jahr zu prognostizieren.

Clustering

Das im Clustering gebräuchliche Verfahren der Clusteranalysewird in zahlreichen Wirtschaftsdisziplinen eingesetzt, wie beispielsweise zur Identifizierung von Marktsegmenten. Das Ziel des Clusterings ist, einen heterogenen Gesamtmarkt anhand bestimmter Merkmale in homogene Segmente zu unterteilen. So können die Angebotsstrukturen des Marktes dementsprechend ausgerichtet werden.

Die Clusteranalyse wird oft auch automatisiert (automatic cluster analysis) durchgeführt. Deshalb ist es eine gute Einsatzmöglichkeit für die Untersuchung von grossen und komplexen Datenbeständen.

Assoziation

Wenn beispielsweise Einkaufs-Produkte in Cluster unterteilt werden sollen, sucht man in den Daten nach den Assoziationen. Die Beziehung zwischen einzelnen Produkten kann in diesem Falle durch eine „wenn/dann“-Regeln beschrieben werden.

CRM (Customer Relationship Management)

Ziel vom CRM ist es, das Kundenverhalten und die Kundenwünsche zu identifizieren um entsprechende Geschäftsstrategien entwickeln zu können. Mithilfe von Kaufhistorien und persönlichen Merkmalen sollen mit dem richtigen Produkteangebot der Kunde langfristig an das Unternehmen gebunden werden. Ausserdem soll durch ein Vorhersagemodell die Abwanderung der Kunden prognostiziert werden können.

Text Mining

Mit Text Mining kann man Texte automatisch Zusammenfassen, aber auch Informationen aus E-Mails oder aus Kundenprofilen nutzen um neue Schlüsse zu ziehen.

Web Mining

Beim Web Mining werden Inhaltsseiten und Zugriffsdaten des Web ausgewertet um beispielsweise treffende Produktangebote für eine möglichst gute Kundenansprache zu finden. Zum Web Mining gehören verschiedene Bereiche, die folgend kurz erläutert werden.

Content Mining

Beim Conect Mining wird das gesamte Web als Datenbank angesehen, die Webseite als Dokument. Ziel ist es, Webseiten mit Informationen zu einem bestimmten Thema zu analysieren

Structure mining

Beim Structure Mining werden Webseiten als Netzwerk angesehen. Die Struktur der Webseite die durch einen Hyperlink definiert ist soll erfasst werden. So werden die Beziehnungen zwischen den Webseiten als Netzwerk interpretiert. Ziel ist es, dieTopologie eines Ausschnitts des Webs zu erfassen um Qualitätsberechnungen durchzuführen.

Diese Methode wird beispielsweise beim Page-Ranking von Suchmaschinen angewendet.

Usage Mining

Die Nutzung des Webs, wie auch die Navigation durch die Webseiten, besonders in welcher Reihenfolge wird bei Usage Mining untersucht. Diese Methode lässt sich ebenfalls sehr gut als Graph darstellen, da die Informationen von Logdateien stammen. Das Ziel ist die Verbesserung der Struktur der Webseiten für ein besseres Angebot individueller Nutzer.

Woher kommen die Daten?

Die Daten stammen grundsätzlich von Datensammlung verschiedener Quellen wie Data Warehouse oder Data Mart und Datenbanken. Man darf aber nicht vergessen, dass sehr früh teilweise eine Selektion der relevanten Daten stattfindet.

Wie im Kapitel Analysemethoden bereits angetönt wurde, sind für verschiedene Methoden unterschiedliche Quellen nötig. So verwendet das „klassische“ Data Mining die Datenbank als Datenquelle, im Unterschied zum Web Mining, welches aus Web Logs die Daten erhebt.

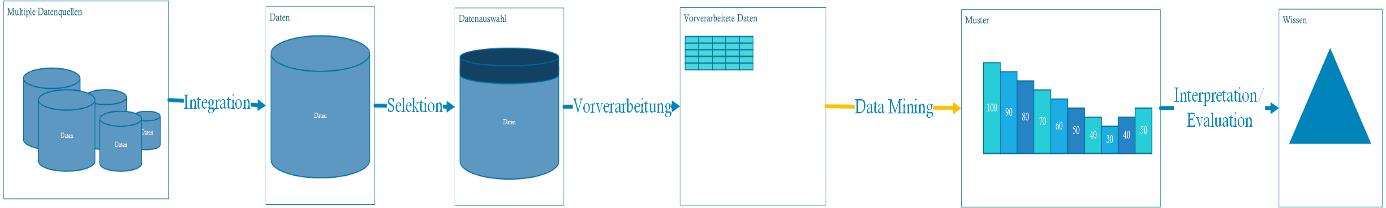

Wie kann man so viele Daten auswerten?

Prozess um neue Erkenntnisse zu gewinnen

1. Beschaffung der Daten aus möglichst vielen internen und externen Quellen 2. Erfassung der Daten in einem Date Warehouse ("Daten-Lagerhaus") 3. Selektion der wichtigen Daten 4. Vorverarbeitung der Daten (Daten in richtige Form bringen) 5. Bearbeitung der Daten mittels Data Mining Tools 6. Auswertung der Daten

Data Mining Tools

Clusteranalyse, Klassifikation, Regression und Mustererkennung gehören zu den typischen Data Mining verfahren. Aus diesen Analysen resultieren zum Beispiel Muster, Regeln oder Beziehungen, welche noch von Experten interpretiert werden müssen. Schliesslich sollten die Ergebnisse allgemein gültig, sinnvoll und verständlich sein.

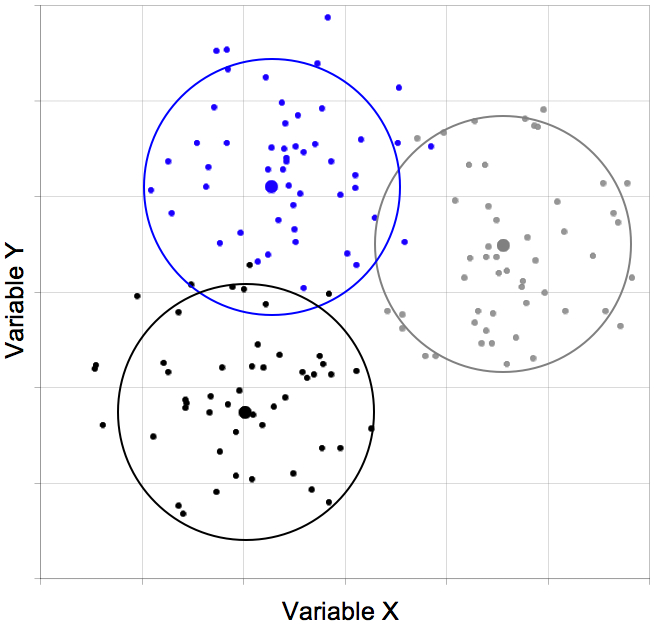

Clusteranalyse

Bei der Clusteranalyse versucht man neue Gruppen in den Daten zu identifizieren (im Gegensatz zur Klassifikation, bei der Daten in bestehende Klassen eingeordnet werden). Dabei sollten die Objekte in einem Cluster/ einer Gruppe möglichst ähnlich sein, und die Objekte verschiedener Cluster möglichst verschieden voneinander sein. Merkmale der zu untersuchende Objekte werden als Zufallsvariablen aufgefasst.

Diese Merkmale werden meist als Punkte in einem Vektorraum dargestellt, deren Umgebung die Eigenschaftsausprägung des Objekts bilden. Bereiche, in denen sich Punkte anhäufen, werden Cluster genannt (siehe Bild).

Die Clusterzahl (Anzahl verschiedener Gruppen) wird durch die Varianz innerhalb und zwischen den Gruppen bestimmt. Dabei sollte man bestimmen, wie viele Gruppen sinnvoll sind (Bestimmung der Trennschärfe der Variablen, Gruppenstabilität). Die zwei Extremfälle: entweder gehören alle Daten zur selben Gruppe, oder jedes Merkmal hat seine eigene Gruppe.

Skalen bezeichnen den Wertebereich, welche die Variable(n) eines Objekts annehmen kann. Es gibt 3 Hauptkategorien von Skalen, welche mit verschiedene Methoden bestimmt werden können:

Binäre Skalen die Variable kann zwei Werte z. B. 0 oder 1 annehmen z. B. männlich/weiblich.

o Jaccard-Koeffizient (Ähnlichkeitsmaß)

o Lance-Williams-Maß (Distanzmaß)

Nominale Skalen die Variable kann unterschiedliche Werte annehmen um eine qualitative Unterscheidung zu treffen, z. B. welcher Studiengang ein Schüler gewählt hat.

o Chi-Quadrat-Maß (Distanzmaß)

o Phi-Quadrat-Maß (Distanzmaß)

Metrische Skalen die Variable nimmt einen Wert auf einer vorher festgelegten Skala eine quantitative Aussage zu treffen z. B. eine Rangliste 1-10.

o Pearson Korrelationskoeffizient (Ähnlichkeitsmaß)

o Euklidische Metrik (Distanzmaß)

o Minkowski-Metrik (Distanzmaß)

Es gibt „harte“ und „weiche“ Clusteralgorithmen. Methoden, welche jeden Datenpunkt genau einem Cluster zuordnen (Bsp. K-means) gehören zu den harten Algorithmen, hingegen lassen Methoden von weichen Algorithmen zu, dass gewisse Datenpunkte nicht oder nur schwach einem Cluster zugeordnet werden. Deswegen sind weiche Methoden insbesondere dann nützlich, wenn die Datenpunkte relativ homogen im Raum verteilt sind und die Cluster nur als Regionen mit erhöhter Datenpunktdichte wahrgenommen werden können.

Assoziationsanalyse

Ziel der Assoziationsanalyse ist es, sogenannte Assoziationsregeln in den Datensätze zu finden, welche Zusammenhänge/Korrelationen zwischen in Transaktionen vorkommenden Objekten beschreiben. Dabei sollen Objekte ermittelt werden, die implizieren, dass gewisse andere Objekte in der Transaktion ebenfalls vorkommen. Zum Beispiel bei der sogenannten Warenkorbanalyse, welche die Zusammenhänge bei Einkäufen beschreibt.

Beispiel einer Assoziationsregel Wurst + Käse -> Brot

Was heisst, dass wenn ein Kunde Wurst und Käse zusammen kauft? -Dass er mit hoher Wahrscheinlichkeit auch Brot kaufen möchte. Mit Erkenntnissen, die durch die Assoziationsanalyse gewonnen werden, ist es möglich, z.B. bestimmte stark korrelierte Produkte getrennt voneinander anzuordnen. Dadurch können Kunden dazu gebracht werden, nicht nur einen Teil des Supermarktes zu besuchen, sondern auch noch an anderen Waren vorbeizukommen, was sich vermutlich in einer Erhöhung des Marktumsatzes niederschlägt.

Klassifikation

Bei der Klassifikation geht es darum, ein Modell zu erstellen, das Datensätze anhand mehrerer Merkmale in eine von mehreren vorgegebenen Klassen einteilt. Beispielsweise möchte eine Versicherung mögliche Kunden anhand der Merkmale Alter, Einkommen, Geschlecht und Familienstand einteilen in die Risikoklassen ”Hoch“ und "Niedrig“. Da sie für zukünftige Kunden nicht weiß, ob ”Hoch“ oder ”Niedrig“ die richtige Risikoklasse ist, muss sie sich bei der Modellerstellung auf schon vorhandene Kunden stützen, von denen sie die Merkmale kennt und auch, in welche Risikoklasse diese fallen. Die Daten, die diese Kunden beschreiben, sind die sogenannten Trainingsdaten. Die Klassifikation kann z.B. mit einem Entscheidungsbaum oder einem Neuronalen Netz durchgeführt werden. Abgrenzung zum Clustering

• Klassifikation: Klassen vorab bekannt

• Clustering: Klassen werden erst gesucht

Resultate

Ansprüche an die Daten

Inputdaten eines Data-Mining-System können Probleme mit sich bringen. Schwierigkeiten können von technischen Ursprungs sein, z.B. bei der Art der Speicherung der Daten, oder auch durch die Unvollkommenheit der Daten selber entstehen.

Unvollständigkeit und Spärlichkeit der Daten

Im Gegensatz zu Datensammlungen für Test- und experimentelle Zwecke, sind Realdatenbanken nicht immer geeignet für Data Mining. Deswegen fehlen oft trotz riesiger Datenmengen wichtige Informationen oder sind unterrepräsentiert.

Dynamik der Daten

Vor allem in Data-Mining-Systeme, welche online arbeiten, verändern sich Daten laufend. Deswegen muss man aufpassen, dass die Änderungen nicht zu falschen Resultaten führen können.

Datenschmutz

Häufig treten auch per Hand zusammengestellte Datensammlungen auf. Bei solchen Sammlungen ist das Risiko für Fahler sehr hoch. Solche Fehler können zu besonders auffällige Muster führen. Mit dem Problem, falsche Dateneingaben aufzufinden und zu korrigieren, beschäftigt sich eine eigene Kategorie von Data-Mining-Systemen. Das Reinigen der Daten selbst kann aber auch zu Probleme führen, z.B. erweisen sich häufig scheinbare Anomalien oder Ausreisser als wesentliche Hinweise auf interessante Muster oder Entwicklungen.

Redundanz

Auch Redundanzen können problematisch sein, vor allem wenn das System diese als neues Wissen interpretiert. Mehrfach vorhandene Datenkönnen zu falschen Muster führen oder Trends verstärken, welche gar nicht so relevant wären.

Irrelevante Felder

Oft sind zahlreiche Felder für die Datenmustererkennung überflüssig, wobei oftmals nicht bekannt ist, auf welche Felder man ohne Informationsverlust verzichten kann.

Datenvolumen

Grosse Volumen an Datensätze verhindern oft, die Algorithmen, welche in kleineren Datensammlungen gute Ergebnisse liefern, zu verwenden, weil diese in grösseren Datensätze zu viel Zeit benötigen oder sogar nicht mehr berechenbar sind.

Qualität der gefundenen Muster:

Verständlichkeit

Die gewonnenen Informationen müssen in einer gut verständlichen Form präsentiert werden, oder in einer Struktur, welche ein Programm zur Weiterverarbeitung benützen könnte.

Entscheidend

Ergebnisse sollten für die Kunden interessant sein. Es sollten keine Trivialdaten erzeugt werden oder Ergebnisse, welche auch mit einfachen Datenbankabfragen zu erhalten wären.

Bekanntheit

Ergebnisse sollten neu sein, und nicht schon von Fachexperten bekannt sein.

Irrelevanz

Resultate sollten Muster darstellen, welche zu einer Verhaltensänderung führen könnten, also nicht solche, bei denen unbeeinflussbare Faktoren eine Rolle spielen.

Beispiel einer Dataminingmethode, welche stark kritisiert wurde

Facebook gab im Jahr 2012 einer fremden Firma –dem auf Polit-News spezialisiertem US-Medium Politico – die Erlaubnis, seine Nutzerdaten zu analysieren. (Wäre auch ein Beispiel zum Thema: Privatsphäre->siehe weiter unten.) Politico untersuchte dabei die Stimmung unter den Nutzern in Bezug auf republikanische Kandidaten bei den US-Vorwahlen in South Carolina am 21. Januar. Dazu wurden sämtliche Statusmeldungen und Kommentare von US-Nutzern darauf analysiert, ob die Namen der Kandidaten in einem positiven oder negativen Zusammenhang erwähnt werden. Diese wurden dann von Software analysiert.

Wie der US-Autor Micah Sifry, in einem Artikel seines Tech-Polit-Magazins TechPresident.com argumentiert, sei die von Facebook verwendete Methode “Sentiment Analysis” aber ein “Schwindel”. Denn einfach Wörter zu zählen und diese als positive oder negative Erwähnung einzustufen, wurde falsche Ergebnisse liefern. Würde etwa ein Facebook-Nutzer schreiben, “I’m so happy that Newt Gingrich is staying in the race”, könne die Analyse nicht feststellen, ob das ehrlich, sarkastisch oder sonst wie gemeint war.

Privatsphäre

Data-Warehousing ("Daten-Lagerhaus") und Data-Mining-Konzepte sind eine Herausforderung für den Datenschutz. Das Ziel der Marketingstrategen war schon immer, die Auswertung des Konsumverhaltens einzelner Gruppen oder Bevölkerungsschichten. Heute erlauben neue Technologien diese Analysen mit einer solchen Präzision durchzuführen, dass das Konsumverhalten einzelner Personen ermittelbar ist. Mit den Ergebnissen solcher Auswertungen, wird versucht das Verhalten einer Person zu steuern, indem Produkte im Hinblick auf ihr mögliches Verhalten angeboten werden. Denn bei Data-Mining Tools, gibt der Kunde ungewollt mehr Daten von sich bekannt, als er eigentlich geben will: Mit der Auswertung der Daten fallen beispielweise Angaben über bestimmte Präferenzen, die Zahlungswahrscheinlichkeit oder die Kundenprofitabilität an.

Datamining ist meist eine sekundäre Zielsetzung der Datensammlung, welche durch die ursprüngliche Zielsetzung nicht abgedeckt wird. Selbst wenn Datamining als Zweckbestimmung einer Datenbearbeitung angegeben wird, ist damit noch nicht gelöst, wie mit den gewonnenen neuen Informationen und Kenntnisse umzugehen ist.

Mit der Einwilligung der betroffenen Person, ist es möglich Datenbearbeitung durchzuführen. Meist wird diese Einwilligung so geholt, dass der Kunde im Rahmen von allgemeinen Geschäftsbedingungen eine Vollmacht unterschreibt, welche eine weitere Bearbeitung seiner Daten für "Marketingzwecken" erlaubt. Für Kunden ist dies wenig transparent, somit wissen sie nicht was mit ihren Daten geschieht und welche Informationen über Sie damit zusätzlich gewonnen werden.

Kunden fürchten sich Opfer von Manipulationen zu werden. In den USA geben gemäss einer Umfrage 75% der Bevölkerung an, dass sie die Kontrolle über ihre persönlichen Daten verloren haben.

In der Schweiz hat eine Umfrage gezeigt, dass 72% der Kunden lieber Nettopreise bezahlen würden als sich mit diversen Kundenbindungs-Programmen herumschlagen zu müssen.

Beispiel von Manipulation: Es kommt in der Schweiz öfters vor, dass Personen in Verfahren involviert werden, weil ihr Kassenzettel in einem nicht offiziellen und daher verbotenen Kehrichtsack gefunden wurde. Ein Grossverteiler versieht auf Grund der Kundenkarte die Kassenzettel mit einer individuellen Nummer, weshalb jeder Zettel identifizierbar wird. Das achtlose Fortwerfen eines Kassenzettels kann deshalb dazu führen, dass er von anderen Personen missbraucht wird, um falsche Fährten zu legen.

Diskriminierung: Mit "scoring" wird ermittelt, welcher Nutzen der Kunde dem Unternehmen gebracht hat, respektive welcher potentielle Nutzen in Zukunft zu erwarten ist. Konsequenzen: die Kunden werden nach "Kundenwert" behandelt. i.d.R kennt der Kunde weder seinen "Wert" noch die Daten, welche zu dieser Erkenntnisse geführt haben.

Fazit

Auf Grund der tatsächlichen Entwicklung, der Rechtslage und der sozialen Risiken ist ein Interessenausgleich zwischen Unternehmen und Konsumenten nur möglich, wenn das Gebot der Fairness spielt. Offensichtlich nutzen Heute die Unternehmen neue Technologien vorwiegend zur Optimierung ihren eigenen Interessen aus, die Vorteile des Konsumenten sind eher schwach, und die Gesetze zum Schutz der Privatsphäre haben nur beschränkte Wirkung.

Wozu?

Data Mining kommt dort zum Einsatz, wo aus grossen Datenmengen in zentralisierten oder verteilten Datenbeständen Mehrwert geschaffen werden soll, z.B. im Marketing (Kundenprofile und Warenkorbanalyse), in der Bioinformatik (Genetik, Molekularbiologie), im Gesundheitswesen (Patientendaten, Versicherungen), sowie bei vielen webAnwendungen (Suchmaschinen, Textdaten und strukturierte Daten).

Kundensegmentierung für Marketing

• Gruppierung von Kunden mit ähnlichem Kaufverhalten / ähnlichen Interessen

• Nutzung für gruppenspezifische Empfehlungen, Product Bundling, ...

Warenkorbanalyse: Produkt-Platzierung im Supermarkt, Preisoptimierung, ...

• Bestimmung der Kreditwürdigkeit von Kunden (elektronische Vergabe von Kreditkarten, schnelle Entscheidung über Versicherungsanträge, ...)

• schnelle Entscheidung erlaubt neue Kunden zu gewinnen

• Technik: Entscheidungsbaum-Klassifikator

Weitere Beispiele:

• Entdeckung wechselbereiter Kunden

• Entdeckung von Kreditkarten-Missbrauch

• Unterstützung im Data Cleaning

• Web Usage Mining

• Text Mining: inhaltliche Gruppierung von Dokumenten, E-Mails, ...

Allgemein über Beispiele

In der Realität ist Data Mining für das eCommerce unabdingbar, da durch die Muster der Käufer der Absatz in den meisten Fällen gesteigert werden kann. Hierzu ein selbsterklärendes Beispiel:

“In 35% der Fälle, in denen Lachs gekauft wird, wird auch Weisswein gekauft.”

http://www.coremine.com/medical/#search http://www.talkorigins.org/faqs/quotes/mine/project.html https://opendata.socrata.com/Government/Most-common-reasons-for-food-recalls/9iuc-3wkn

Quellenverzeichnis

Links

http://www.geo.uzh.ch/~plaube/pubs/laubeRunderTischGIS11.pdf (Cluster) http://dbs.uni-leipzig.de/file/dw-kap6.pdf (Data Mining Analysen) https://ai.wu.ac.at/~koch/courses/wuw/archive/inf-sem-ws-00/nentwich/#31) (Resultate) http://www.jakkse.com/facebook-datamining-ohne-zustimmung-der-nutzer/ (Resultate) http://en.wikipedia.org/wiki/Data_mining (allgemein)

Arbeiten

Data Mining und Data Warehousing:Kundendaten als Ware oder geschütztes Gut?*Dr. Bruno BaeriswylDatenschutzbeauftragter des Kantons Zürich (Privatsphäre)

©Davina Golomingi / Fabienne Pfister